来源:半导体行业不雅察

作家:杜芹DQ

AI这“破天的华贵”,谁都不念念错过。尽管摩尔定律贴近极限,芯片性能的普及变得愈加艰巨。但各大厂商依然以令东说念主提神的速率推出新一代居品,在近日召开的台北国外电脑展上,英伟达、AMD和英特尔三大芯片巨头皆聚一堂,纷纷秀出自家肌肉,推出了下一代AI芯片。

英伟达的Hopper GPU/Blackwell/Rubin、AMD的Instinct 系列、英特尔的Gaudi芯片,这场AI芯片争霸战拼什么?这是速率之争,以英伟达为首,几家巨头将芯片推出速率普及到了一年一代,展现了AI领域竞争的“芯”速率;是时候的角逐,怎样让芯片的盘算速率更快、功耗更低更节能、更易用上手,将是各家的身手。

尽管各家厂商在AI芯片方面各有侧重,但细看之下,其实存在着不少的共同点。

一年一代,展现AI领域“芯”速率

诚然摩尔定律依然运转有些穷苦,然则AI芯片“狂欢者们”的立异措施以及芯片推出的速率却越来越快。英伟达Blackwell还在势头之上,关联词在不到3个月后的Computex大会上,英伟达就又祭出了下一代AI平台——Rubin。英伟达首席推论官黄仁勋暗示,以后每年都会发布新的AI芯片。一年一代芯片,再次刷新了AI芯片的更替速率。

英伟达的每一代GPU都会以科学家名字来定名。Rubin亦然一位好意思国女天文体家Vera Rubin的名字定名。Rubin将配备新的GPU、名为Vera的新CPU和先进的X1600 IB相聚芯片,将于2026年上市。

目下,Blackwell和Rubin都处于全面开发阶段,其一年前在2023年在Computex上发布的GH200 Grace Hopper“超等芯片”才刚全面进入坐褥。Blackwell将于本年晚些时候上市,Blackwell Ultra将于2025年上市,Rubin Ultra将于2027年上市。

紧跟英伟达,AMD也公布了“按年节拍”的AMD Instinct加快器道路图,每年推出一代AI加快器。Lisa Su在会上暗示:“东说念主工智能是咱们的要紧任务,咱们正处于这个行业令东说念主难以置信的慷慨东说念主心的时间的运转。”

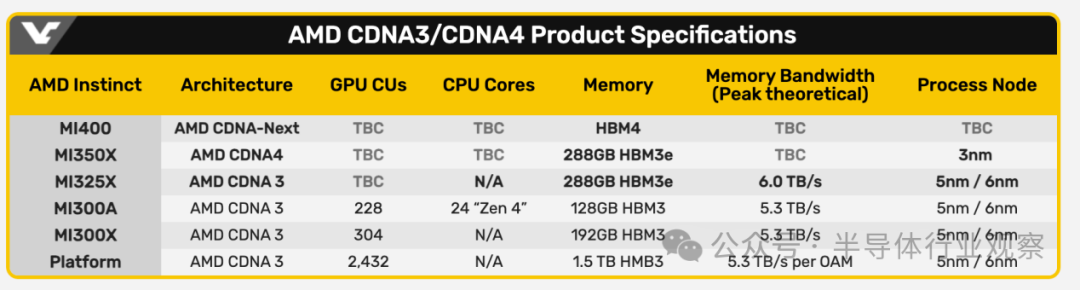

继客岁推出了MI300X,AMD的下一代MI325X加快器将于本年第四季度上市,Instinct MI325X AI加快器不错看作是MI300X系列的强化版,Lisa Su称其速率更快,内存更大。随后,MI350系列将于2025岁首次亮相,秉承新一代AMD CDNA 4架构,瞻望与秉承AMD CDNA 3的AMD Instinct MI300系列比较,AI推感性能将提高35倍。MI350对主义是英伟达的Blackwell GPU,按照AMD的数据,MI350系列瞻望将比英伟达B200居品多提供50%的内存和20%的盘算TFLOP。基于AMD CDNA“Next”架构的AMD Instinct MI400系列瞻望将于2026年上市。

英特尔诚然战略相对保守,然则却正在通过价钱来取胜,英特尔推出了Gaudi东说念主工智能加快器的积极订价战略。英特尔暗示,一套包含八个英特尔Gaudi 2加快器和一个通用基板的模范数据中心AI套件将以65,000好意思元的价钱提供给系统提供商,这约莫是同类竞争平台价钱的三分之一。英特尔暗示,一套包含八个英特尔Gaudi 3加快器的套件将以125,000好意思元的价钱出售,这约莫是同类竞争平台价钱的三分之二。AMD和Nvidia诚然不公开研究其芯片的订价,但字据定制处事器供应商Thinkmate的说法,配备八个Nvidia H100 AI芯片的同类HGX处事器系统的本钱可能跨越30万好意思元。

一齐大叫大进的芯片巨头们,新址品发布速率和订价突显了AI芯片市集的竞争厉害进度,也让繁密AI初创芯片玩家望其肩背。不错料念念,三大芯片巨头将分食大部分的AI市集,多数的AI初创公司分得少许点羹汤。

工艺奔向3纳米

AI芯片走向3纳米是势在必行,这包括数据中心乃至旯旮AI、末端。3纳米是目下起先进工艺节点,3纳米工艺带来的性能普及、功耗贬低和晶体管密度加多是AI芯片发展的热切驱能源。关于高能耗的数据中心来说,3纳米工艺的低功耗特色至关热切,它大约有用贬低数据中心的运营本钱,缓解数据中心的能源压力,并为绿色数据中心的开发提供热切撑抓。

英伟达的B200 GPU功耗高达1000W,而由两个B200 GPU和一个Grace CPU组成的GB200治理决议滥用高达2700W的功率。这么的功耗使得数据中心难以为这些盘算GPU的大型集群提供电力和冷却,因此英伟达必须选择措施。

Rubin GPU的想象目的之一是截止功耗,天风国外证券分析师郭明錤在X上写说念,Rubin GPU很可能秉承台积电3纳米工艺时候制造。另据外媒先容,Rubin GPU将秉承4x光罩想象,并将使用台积电CoWoS-L封装时候。与基于Blackwell的居品比较,Rubin GPU是否果真大约贬低功耗,同期较着提高性能,或者它是否会专注于性能效果,还有待不雅察。

AMD Instinct系列此前一直秉承5纳米/6纳米双节点的Chiplet模式,而到了MI350系列,也升级为了3纳米。半导体盛名分析师陆行之暗示,要是英伟达在加快需求下对台积电下单需求量大,可能会让AMD得不到豪阔产能,转而向三星下订单。

来源:videocardz

来源:videocardz

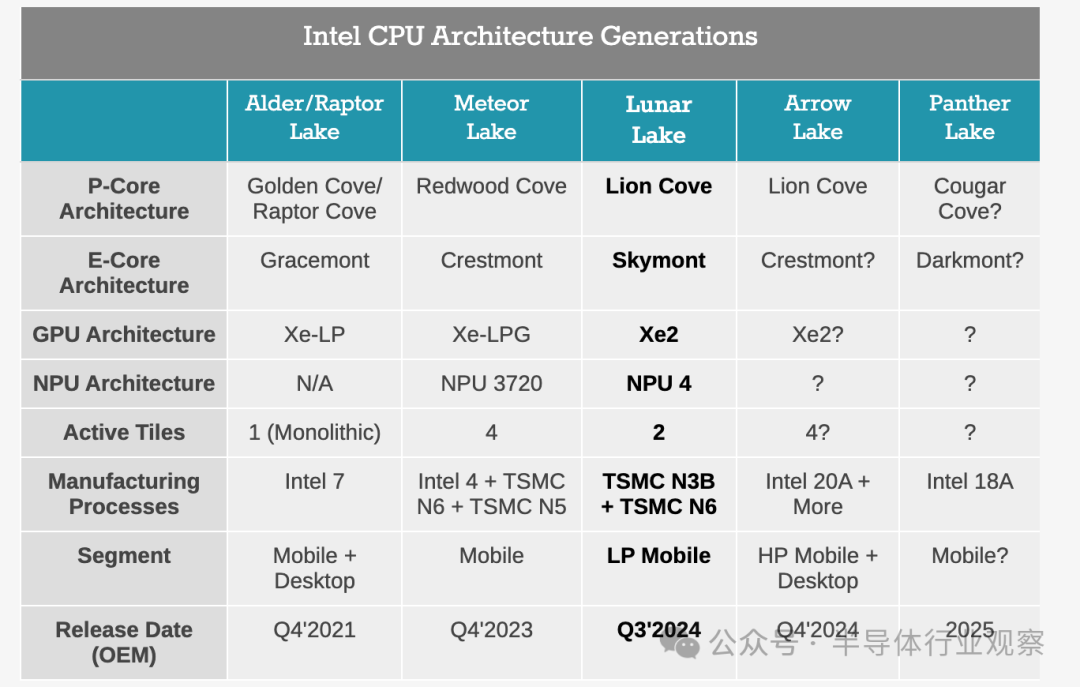

英特尔用于生成式AI的主打芯片Gaudi 3秉承的是台积电的5纳米,关于 Gaudi 3,这部分竞争正在稍微削弱。不外,英特尔的重点似乎更侧重于AI PC,从英特尔最新发布的PC端Lunar Lake SoC来看,也依然使用了3纳米。Lunar Lake包含代号为Lion Cove的新 Lion Cove P核想象和新一波Skymont E 核,它取代了 Meteor Lake 的 Low Power Island Cresmont E 核。英特尔已露馅其秉承 4P+4E(8 核)想象,禁用超线程/SMT。所有这个词盘算块,包括P核和E核,都确立在台积电的N3B节点上,而SoC块则使用台积电N6节点制造。

英特尔历代PC CPU架构

(来源:anandtech)

在旯旮和末端AI芯片领域,IP大厂Arm也在本年5月发布了用于智高手机的第五代 Cortex-X 内核以及带有最新高性能图形单位的盘算子系统 (CSS)。Arm Cortex-X925 CPU就运用了3纳米工艺节点,收获于此,该CPU单线程性能提高了36%,AI性能普及了41%,不错权臣提高如大谈话模子(LLM)等开发端生成式AI的反映智力。

高带宽内存(HBM)是必需品

HBM(High Bandwidth Memory,高带宽存储器)依然成为AI芯片弗成或缺的要道组件。HBM时候履历了几代发展:第一代(HBM)、第二代(HBM2)、第三代(HBM2E)、第四代(HBM3)和第五代(HBM3E),目下正在积极发展第六代HBM。HBM不停冲破性能极限,欢叫AI芯片日益增长的带宽需求。

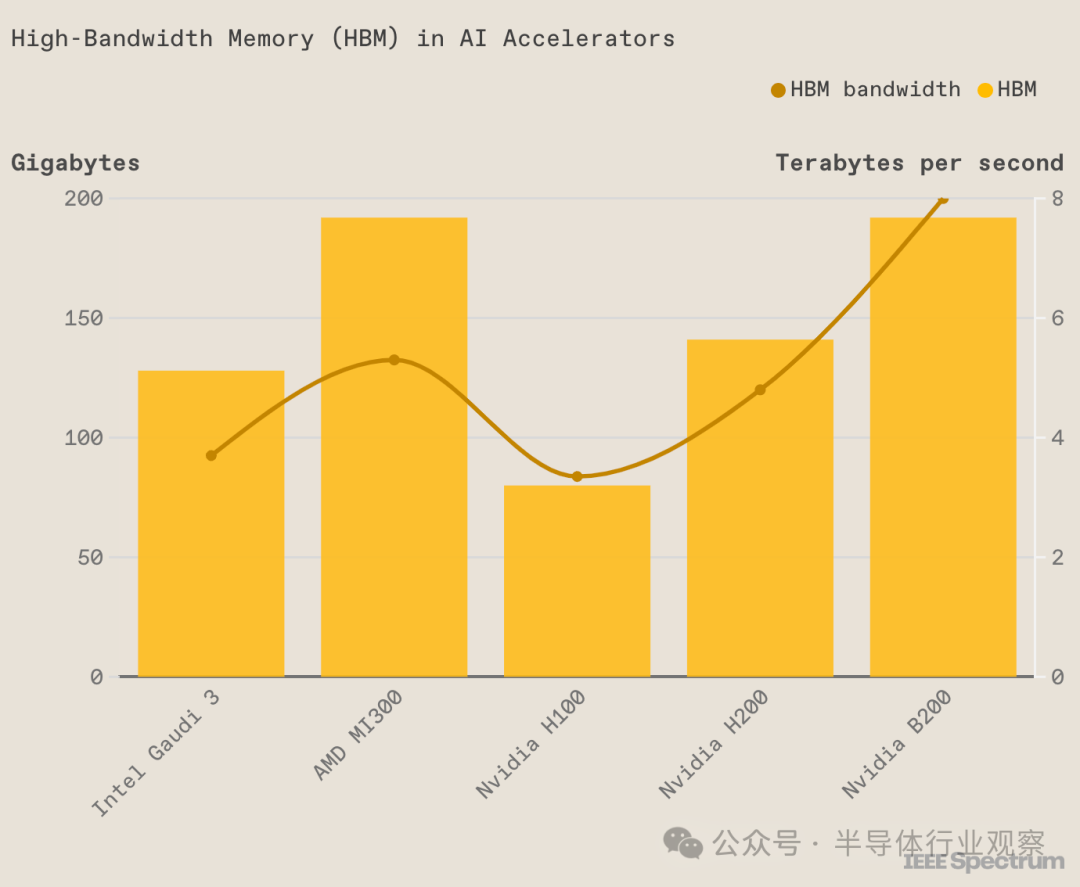

在目下一代的AI芯片当中,各家基本依然都接踵秉承了第五代HBM-HBM3E。举例英伟达Blackwell Ultra中的HBM3E加多到了12颗,AMD MI325X领有288GB的HBM3e内存,比MI300X多96GB。英特尔的 Gaudi 3封装了八块HBM芯片,Gaudi 3大约如斯拼性价比,可能很热切的少许亦然它使用了较低廉的HBM2e。

英特尔Gaudi 3的HBM比H100多,但比H200、B200或AMD的MI300都少

(来源:IEEE Spectrum)

至于下一代的AI芯片,险些都依然拥抱了第六代HBM-HBM4。英伟达Rubin平台将升级为HBM4,Rubin GPU内置8颗HBM4,而将于2027年推出的Rubin Ultra则更多,使用了12颗HBM4。AMD的MI400也奔向了HBM4。

从HBM供应商来看,此前AMD、英伟达等主要秉承的是SK海力士。但当今三星也正在积极打入这些厂商里面,AMD和三星目下都在测试三星的HBM。6月4日,在台北南港展览馆举行的新闻发布会上,黄仁勋回话了关系三星何时能成为 Nvidia 和洽伙伴的问题。他暗示:“咱们需要的 HBM 数目至极大,因此供应速率至关热切。咱们正在与三星、SK 海力士和好意思光和洽,咱们将收到这三家公司的居品。”

HBM的竞争也很尖锐化。SK海力士开首盘算在2026年量产HBM4,但已将那时候表调遣为更早。三星电子也文书盘算来岁开发HBM4。三星与SK海力士围绕着HBM的竞争也很厉害,两家在本年将20%的DRAM产能转向HBM。好意思光也已加入到了HBM大战行列。

炙手可热的HBM也成为了AI芯片大领域量产的制肘。目下,存储大厂SK Hynix到2025年之前的HBM4产能已基本售罄,供需矛盾日益突显。字据SK海力士预测,AI芯片的闹热带动HBM市集到2027年将出现82%的复合年增长率。分析师也觉得,瞻望来岁HBM市集将比本年增长一倍以上。

三星电子DRAM居品与时候推论副总裁Hwang Sang-joon在KIW 2023上暗示:“咱们客户刻下的(HBM)订单决定比客岁加多了一倍多。”三星芯片认真业务的开发治理决议部门总裁兼认真东说念主 Kyung Kye-hyun 在公司会议上更暗示,三星将努力拿下一半以上的HBM市集。三星内存业务推论副总裁Jaejune Kim对分析师暗示,该公司将在2023年至2024年间将其HBM产能加多一倍。

互联:热切的拼图

AI芯片之间互联一直是个难题,跟着连年来越来越多的加快器被集成到一齐,怎样高效传输数据成为了瓶颈。由于PCIe时候的发展速率跟不上时间需求,目下主流的AI芯片厂商都依然自研了互联时候,其中较为代表的即是英伟达的NVLink和AMD的Infinity Fabric。

NVIDIA的下一代Rubin平台,将秉承NVLink 6交换机芯片,运行速率为3600GB/s,上一代的Blackwell秉承的是NVLink 5.0。NVLink想象之初,即是为了治理传统的PCI Express (PCIe) 总线在处理高性能盘算任务时带宽不及的问题。下图浮现了英伟达各代NVLink的参数情况。

各代NVLink的性能参数

各代NVLink的性能参数

与英伟达的NVLink一样,AMD则推出了其Infinity Fabric时候,AMD Infinity 架构与第二代 AMD EPYC处理器一同推出,使系统构建者和云架构师大约开释最新的处事器性能,同期又不葬送功能、可督察性或匡助保护组织最热切钞票(数据)的智力。Infinity Fabric支抓芯片间、芯片对芯片,以及行将推出的节点对节点的数据传输。

英特尔则所以太网的坚实拥护者,英特尔的用于生成式AI的Gaudi AI芯片则一直沿用传统的以太网互联时候。Gaudi 2每个芯片使用了24个100Gb以太网链路;Gaudi 3也使用了24个200Gbps以太网RDMA NIC,然则他们将这些链路的带宽加多了一倍,达到200Gb/秒,使芯片的外部以太网I/O总带宽达到8.4TB/秒。

拼处事

诸如ChatGPT这么的生成式AI开发任务极其复杂,大模子需要在多台盘算机上运行数十亿到数万亿个参数,它需要在多个GPU上并行推论使命,秉承张量并行、活水线并行、数据并行等多种并行处理方法,以尽可能快地处理任务。

因此,怎样大约匡助用户更快的开发,提供致密的处事亦然要道一役。

在这方面,英伟达推出了一种新式的软件NIMS,即NVIDIA Inference Microservices(推理微处事)。黄仁勋称之为“盒子里的东说念主工智能”,NIMS中包含了英伟达的CUDA、cuDNN、TensorRT、Triton。NIMS 不仅使部署 AI 变得更容易,只需几分钟而不是几个月,它们还组成了客户不错创建新应用方法和治理新问题的构建块。要是秉承,NIMS 将有助于加快立异并贬廉价值罢了时候。Nvidia 还文书,NIMS 当今可供开发东说念主员和研究东说念主员免费使用。在坐褥中部署NIMS需要AI Enterprise许可证,每个GPU的价钱为4500好意思元。

结语

下一场AI之战果决打响,空洞来看,刻下AI芯片市集上,英伟达、AMD和英特尔等主要芯片巨头正在张开厉害的竞争。他们不仅在速率、时候和工艺方面竞相立异,还在互联和处事等领域积极拓展,勉力于为用户提供更快、更强、更智能的AI治理决议。AI芯片争霸战仍在陆续,谁能最终胜出?让咱们翘首跂踵。

股市回暖,抄底炒股先开户!智能定投、要求单、个股雷达……送给你>>

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

包袱剪辑:刘万里 SF014开yun体育网